El fine-tuning de los modelos Meta Llama 3.1 con Amazon SageMaker JumpStart está revolucionando la personalización de la inteligencia artificial generativa. Los desarrolladores ahora pueden ajustar estos modelos de fundación, que son de acceso público, para adaptarlos a las necesidades específicas de sus proyectos. La colección Meta Llama 3.1 representa un avance significativo ofreciendo un amplio rango de capacidades para la creación de aplicaciones innovadoras. Estos modelos están disponibles en varios tamaños, con 8 mil millones, 70 mil millones y 405 mil millones de parámetros, permitiendo una amplia flexibilidad en su aplicación.

Lo que destaca de los modelos Meta Llama 3.1 es su capacidad para comprender y generar texto con notables coherencia y matices. Con una longitud de contexto de hasta 128,000 tokens, pueden mantener una profunda conciencia contextual, factor clave para manejar tareas de lenguaje complejas. Además, están optimizados para una inferencia eficiente, integrando técnicas avanzadas como la atención de consulta agrupada (GQA) que permite respuestas rápidas.

Una característica destacable de estos modelos es su destreza multilingüe. Las versiones instrucción-tuneladas sólo de texto (8B, 70B, 405B) han sido diseñadas para el diálogo en lenguaje natural, demostrando superar a muchos chatbots públicos en ensayos de la industria. Esto los hace ideales para crear experiencias conversacionales multilingües, eliminando barreras lingüísticas y ofreciendo a los usuarios interacciones más inmersivas.

En el núcleo de los modelos Meta Llama 3.1 se encuentra una arquitectura de transformador autoregresivo optimizada. Las versiones afinadas de estos modelos incorporan avanzadas técnicas de fine-tuning como el entrenamiento supervisado (SFT) y el aprendizaje por refuerzo con retroalimentación humana (RLHF), que alinean las salidas del modelo con las preferencias humanas. Este nivel de refinamiento abre nuevas posibilidades para los desarrolladores, permitiendo adaptar poderosos modelos de lenguaje a las demandas únicas de sus aplicaciones.

El proceso de fine-tuning implica ajustar los pesos de los modelos preentrenados Meta Llama 3.1 usando nuevos datos, mejorando así su desempeño en tareas específicas. Este proceso involucra entrenar al modelo en un conjunto de datos adaptado a la tarea y actualizar los pesos para ajustarlos a los nuevos datos, lo que puede resultar en mejoras significativas con un esfuerzo mínimo. Esto permite a los desarrolladores cumplir rápidamente con las necesidades de sus aplicaciones.

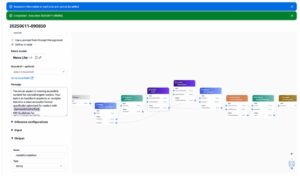

SageMaker JumpStart ahora soporta los modelos Meta Llama 3.1, facilitando a los desarrolladores explorar el fine-tuning del modelo Meta Llama 3.1 405B a través de su interfaz de usuario y SDK. Se proporcionan ejemplos de fine-tuning sin código usando la interfaz de usuario de SageMaker JumpStart, así como con el SDK. Esto es útil para construir chatbots multilingües, asistentes generadores de código y otras aplicaciones de IA generativa.

Con SageMaker JumpStart, se puede elegir entre una amplia selección de modelos fundacionales de acceso público. Es posible desplegar modelos en instancias dedicadas de Amazon SageMaker desde un entorno aislado en red y personalizar estos modelos usando SageMaker para el entrenamiento y despliegue. SageMaker JumpStart ofrece configuraciones predeterminadas para el fine-tuning de las variantes Meta Llama 3.1 405B, 70B, y 8B utilizando la técnica QLoRA, con una tabla resumen que muestra los diferentes modelos y sus correspondientes configuraciones de entrenamiento.

En conclusión, SageMaker JumpStart facilita el fine-tuning y despliegue de modelos Meta Llama 3.1, proporcionando recomendaciones para el entrenamiento optimizado basadas en pruebas realizadas. Los resultados muestran que el fine-tuning mejora la capacidad de resumen en comparación con los modelos no afinados. Como próximo paso, se pueden usar los códigos proporcionados en el repositorio de GitHub para intentar el fine-tuning y evaluar los resultados para casos de uso específicos.