El mundo de la inteligencia artificial y los modelos de lenguaje grandes (LLM) avanza rápidamente hacia técnicas más eficientes y adaptables gracias a la innovación continua en el ajuste fino de modelos preentrenados. Actualmente, una nueva propuesta ha salido a la luz que promete revolucionar este campo gracias a un marco de ajuste fino auto-instruido continuo, que busca mantener la eficacia y precisión de los LLM en entornos que cambian constantemente.

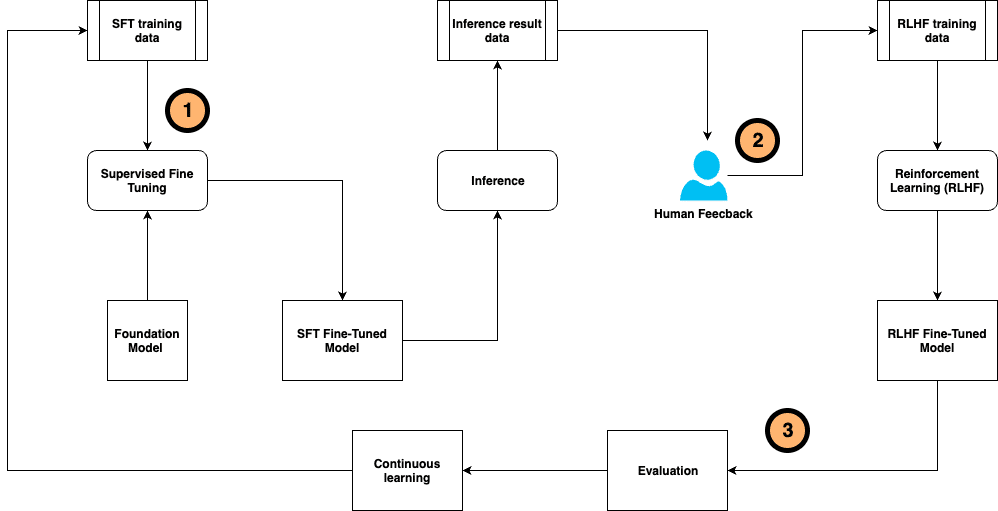

El ajuste fino de estos modelos es esencial para personalizarlos y que realicen tareas específicas de manera más efectiva. Este proceso continuo garantiza que el modelo se mantenga al día con la evolución de los datos, evitando así una degradación en su rendimiento. Una técnica ampliamente utilizada en este contexto es el ajuste fino supervisado (SFT), complementado por la afinación de instrucciones que se basa en directrices anotadas manualmente. A través de la retroalimentación humana, se puede aplicar el aprendizaje por refuerzo para orientar y mejorar la precisión de las respuestas generadas por el modelo.

Sin embargo, el camino hacia la precisión no es sencillo. El proceso de anotación manual y recolección de comentarios de los usuarios demanda un esfuerzo considerable en términos de tiempo y recursos. Para responder a estos desafíos, nace un marco innovador que unifica la generación de datos, el entrenamiento y la evaluación del modelo, así como la recolección de retroalimentación, en un solo sistema. Este marco está diseñado para ser más eficiente y adaptable, permitiendo un ajuste continuo que se ajusta a las demandas cambiantes del entorno.

Este avanzado sistema propone un flujo de trabajo que, a partir de muestras de entrenamiento etiquetadas por humanos, personaliza el modelo base. Este flujo continuo no solo facilita la personalización, sino que también permite al sistema aprender y adaptarse a medida que recibe nueva información y retroalimentación.

Además, el desarrollo de este enfoque ha dado paso a la creación de un sistema de IA compuesto para superar las limitaciones de los modelos tradicionales. La interacción entre diversos componentes dentro de este sistema posibilita soluciones más innovadoras y eficientes. Por ejemplo, se ha introducido DSPy, un nuevo marco de programación de Python de código abierto que simplifica la creación de aplicaciones LLM. Este marco está diseñado para optimizar tanto los resultados como la experiencia del usuario, promoviendo una mayor flexibilidad en el desarrollo y el mantenimiento de soluciones IA.

La implementación de este sistema de ajuste fino contínuo representa un avance significativo para mejorar la precisión y eficiencia de los modelos de lenguaje, proporcionando un marco más robusto que maximice su reutilización y adaptabilidad en un mundo de datos en constante cambio.