La herramienta permite animar imágenes estáticas en segundos y se suma a la competencia con Sora (OpenAI), Veo (Google) y Kling (ByteDance)

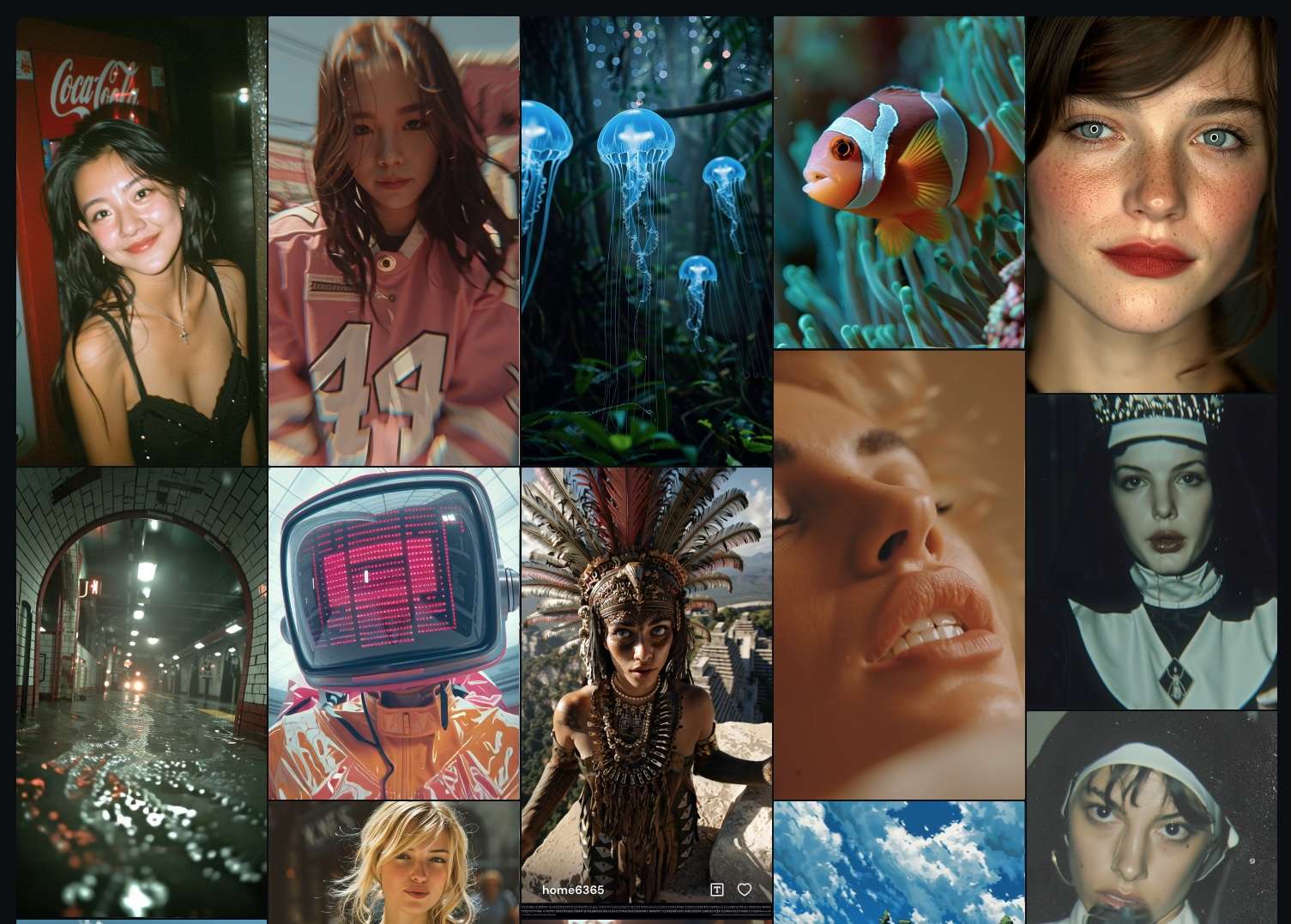

Midjourney, conocida por su plataforma de generación de imágenes mediante inteligencia artificial, ha dado un salto importante con el lanzamiento de V1, su primer modelo de vídeo. Esta nueva herramienta permite animar imágenes estáticas en clips de cinco segundos, extensibles hasta veinte, directamente desde el navegador y sin necesidad de conocimientos técnicos avanzados. Con esta apuesta, la compañía entra oficialmente en la intensa carrera por liderar el futuro del contenido visual generado por IA.

A diferencia de modelos más complejos como Sora, de OpenAI, o Veo, de Google DeepMind, Midjourney V1 opta por un enfoque más accesible, rápido y visual. Su propuesta se centra en la simplicidad: partir de una imagen (creada en Midjourney o cargada por el usuario), pulsar “Animate” y ver cómo cobra vida en segundos. Cada imagen da lugar a cuatro vídeos diferentes de cinco segundos, y los usuarios pueden añadir instrucciones para controlar el movimiento de la cámara o los personajes.

¿Cómo se compara V1 con Sora, Veo y Kling?

| Modelo | Empresa | Entrada principal | Longitud del vídeo | Foco principal | Nivel de control | Disponibilidad |

|---|---|---|---|---|---|---|

| V1 | Midjourney | Imagen estática + prompt | 5–20 segundos | Animación simple desde imagen | Bajo / medio | Web (limitado) |

| Sora | OpenAI | Texto | Hasta 1 minuto | Simulación realista y narrativa | Alto | Cerrado (por ahora) |

| Veo | Google DeepMind | Texto | 1 minuto (aprox.) | Calidad cinematográfica | Medio / alto | Acceso limitado |

| Kling | ByteDance | Texto + imagen | 2–4 segundos | Movimiento realista y sincronización labial | Medio | Limitado (China) |

Mientras Sora y Veo buscan crear vídeos más largos y con apariencia cinematográfica a partir de descripciones textuales, Midjourney V1 se diferencia por su flujo visual directo: primero se genera una imagen atractiva, y luego se anima. Esto convierte a V1 en una herramienta ideal para creadores de contenido visual, diseñadores o usuarios que quieran obtener resultados rápidos y estéticamente cuidados sin pasar por complejos prompts textuales.

Por su parte, Kling, de ByteDance (matriz de TikTok), ha sorprendido recientemente con vídeos de alta precisión en movimiento y expresividad facial, aunque con una duración más limitada y aún sin acceso general fuera de China.

Modos de uso y características de V1

Midjourney V1 incluye:

- Modo automático, en el que la IA interpreta cómo debería moverse la escena.

- Modo manual, donde el usuario describe la animación con un «motion prompt».

- Dos niveles de movimiento: bajo (ideal para escenas sutiles) y alto (más dinámico, pero con mayor riesgo de errores visuales).

- Compatibilidad con imágenes externas, que se pueden cargar directamente en la plataforma para animar.

Además, los vídeos pueden extenderse en bloques de 4 segundos, hasta un máximo de 20, ofreciendo cierto grado de continuidad narrativa, aunque lejos todavía de la duración y complejidad de los modelos de OpenAI o Google.

Precio y acceso

Generar un vídeo en Midjourney cuesta unas ocho veces más que generar una imagen, lo que sitúa el coste por segundo en torno al precio de una imagen individual. La empresa afirma que este modelo es 25 veces más barato que soluciones anteriores del mercado, y está disponible exclusivamente en la versión web para todos los usuarios, aunque se recomienda tener una suscripción superior para obtener tiempos de espera más reducidos.

Midjourney también está probando un modo relax para vídeo destinado a usuarios del plan Pro y superiores.

Un paso hacia la simulación del mundo real

V1 es solo una pieza dentro del proyecto más amplio que Midjourney tiene entre manos: construir una plataforma de simulación abierta en tiempo real, donde el usuario pueda desplazarse por entornos 3D, interactuar con objetos y personajes, y crear mundos completos de forma generativa.

“La dirección hacia la que nos dirigimos son modelos capaces de simular el mundo en tiempo real”, explica la compañía. “Primero creamos imágenes, ahora las hacemos moverse, luego construiremos modelos 3D, y finalmente todo esto deberá funcionar de forma fluida y en tiempo real”.

¿Y los riesgos?

El anuncio de V1 coincide con una polémica legal: Disney y Universal han demandado a Midjourney por supuestamente entrenar sus modelos con contenido protegido por derechos de autor. En los documentos se citan imágenes generadas por usuarios que reproducen a la perfección personajes como Homer Simpson o Darth Vader.

La empresa ha hecho un llamado a la responsabilidad en el uso de estas herramientas: “Usadas correctamente, no solo son divertidas. Pueden ser útiles, educativas e incluso profundas”.

Un campo en expansión

El lanzamiento de V1 por parte de Midjourney marca una nueva etapa en la evolución de los contenidos generados por IA. Aunque aún limitado en duración y control, ofrece una alternativa accesible, rápida y creativa frente a las propuestas más avanzadas —pero menos accesibles— de OpenAI, Google y ByteDance.

La competencia se intensifica, y el vídeo generado por IA se perfila como la próxima gran frontera de la creatividad digital. Midjourney, con su enfoque visual y su comunidad consolidada, está decidida a formar parte de ese futuro.

Fuente: Noticias inteligencia artificial