La implementación de asistentes impulsados por inteligencia artificial generativa está convirtiéndose rápidamente en una práctica estándar para las empresas que buscan optimizar y agilizar sus operaciones. Sin embargo, antes de desplegar estas avanzadas aplicaciones tecnológicas, es necesario realizar una minuciosa evaluación de preparación para la producción, cuyo enfoque principal es la seguridad. Si los riesgos de seguridad no se identifican claramente desde el principio, el lanzamiento de la aplicación podría verse retrasado, afectando a las metas corporativas.

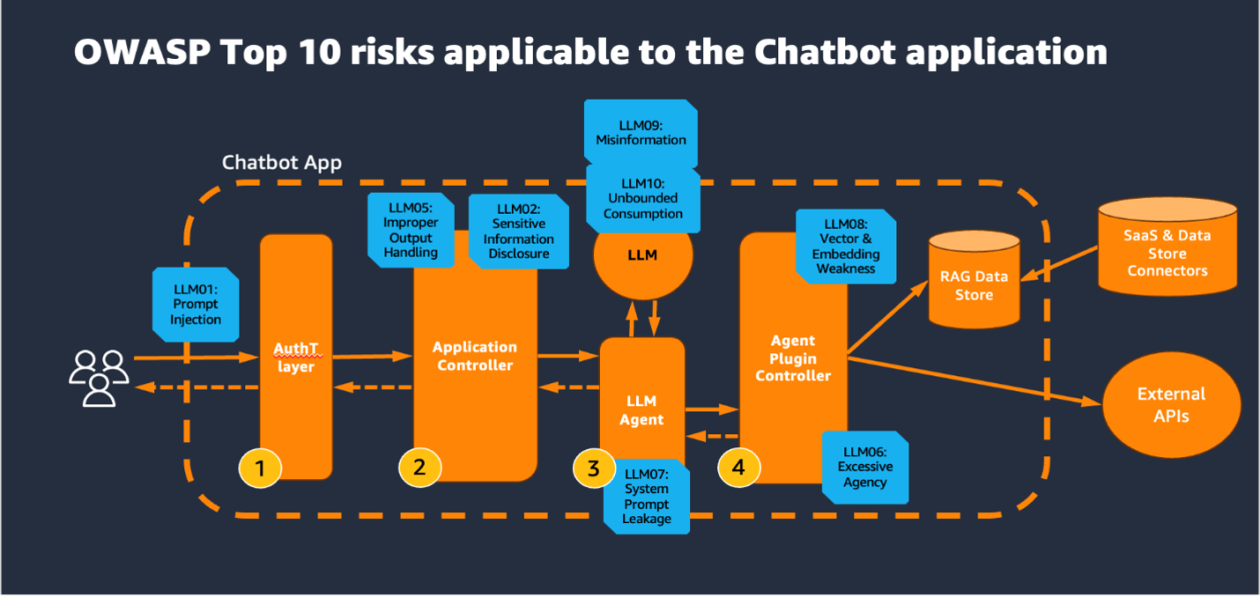

Para afrontar estas preocupaciones referentes a la seguridad, muchas organizaciones recurren al marco de evaluación de seguridad proporcionado por la OWASP. Esta entidad ha actualizado su conocido Top 10 para Aplicaciones de Modelos de Lenguaje Grande (LLM), ofreciendo un valioso recurso para identificar, comprender y mitigar potenciales amenazas que afectan a aplicaciones de inteligencia artificial generativa. Estas pautas proporcionan a las empresas las mejores prácticas en seguridad para abordar nuevos desafíos en el campo de la IA.

Un elemento esencial dentro de estas evaluaciones de seguridad es el establecimiento de arquitecturas lógicas para las aplicaciones de asistencia de IA generativa. Estas arquitecturas deben estar estructuradas con capas de seguridad efectivas, responsables de aspectos como la autenticación de usuarios y la gestión de la salida de los datos generados por los modelos LLM. Herramientas avanzadas como AWS Cognito y AWS WAF resultan cruciales para validar los usuarios conectados e inmunizar la aplicación contra ataques comunes de denegación de servicio.

Además, la implementación de medidas de seguridad adaptativas es fundamental. Estrategias como la autenticación multifactor, la imposición de límites de tasa y la gestión de sesiones seguras son vitales para prevenir accesos no autorizados. También es crucial que la capa de control de la aplicación, a menudo vulnerable a ataques de inyección de comandos, esté equipada con robustos controles de seguridad, como la validación exhaustiva de entradas.

Conforme las aplicaciones de inteligencia artificial generativa evolucionan, la evaluación y mitigación de riesgos adquieren una importancia creciente para asegurar que estas soluciones sean seguras y operativas en entornos de producción. Adoptar un enfoque proactivo en la seguridad no solo protege las aplicaciones, sino que también fomenta la confianza de los usuarios y clientes en el uso de estas tecnologías emergentes.