Las empresas enfrentan una presión creciente para demostrar el retorno de la inversión en proyectos de inteligencia artificial, ya sea mediante aprendizaje automático predictivo o IA generativa. Sin embargo, llevar estos proyectos a la etapa de producción es un desafío considerable. Actualmente, solo el 54% de los prototipos de aprendizaje automático lo logran, y apenas un 5% de los proyectos de IA generativa alcanzan este hito. La clave no es solo poner los proyectos en marcha, sino asegurar precisión y rendimiento en modelos que deben ser escalables y confiables, con alta precisión y baja latencia.

Un ejemplo evidente de la necesidad de baja latencia es la detección de fraudes. Las decisiones rápidas son cruciales, como el tiempo que toma pasar una tarjeta de crédito por un lector. Con un aumento significativo en los fraudes, muchas organizaciones están reforzando sus sistemas de detección. En 2023, las pérdidas por fraude en Estados Unidos superaron los $10 mil millones, un aumento del 14% respecto al año anterior. Además, se prevé que el fraude en el comercio electrónico a nivel global exceda los $343 mil millones para 2027.

Desarrollar una aplicación de inteligencia artificial precisa y confiable para combatir esta problemática es una tarea compleja. Los equipos de aprendizaje automático deben conectar manualmente diversos componentes de infraestructura, lo cual se complica al trabajar con fuentes de datos en tiempo real y pasar de inferencias por lotes a servicios en tiempo real.

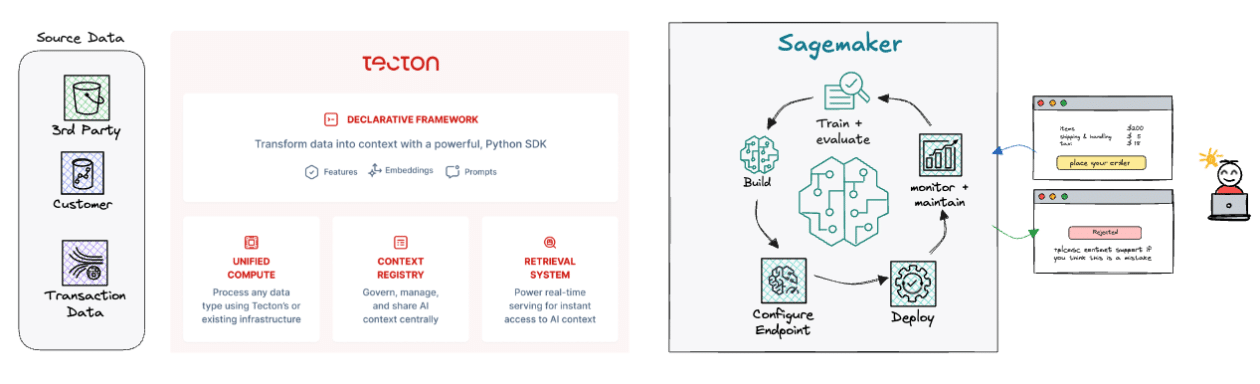

Los ingenieros se enfrentan al reto de construir y orquestar tuberías de datos, manejar distintas necesidades de procesamiento, y gestionar la infraestructura para ofrecer inferencias confiables. Sin las capacidades que ofrece Tecton, estas tareas serían arduas y difíciles de manejar.

Para abordar esta complejidad, Tecton junto a Amazon SageMaker simplifican el trabajo de ingeniería necesario para implementar aplicaciones de inteligencia artificial en tiempo real. Esto acelera el tiempo para obtener valor y permite que los equipos se concentren en innovar, en vez de luchar con la gestión de infraestructura existente.

Tecton proporciona un marco de trabajo declarativo sencillo para definir transformaciones necesarias en las características de los modelos, construyendo las tuberías necesarias para calcular, gestionar y servir estas características. Su integración con almacenes de datos y el soporte de caché en memoria para características a través de una API REST de baja latencia, cumple con las exigencias de casos de uso como la detección de fraudes.

Esta infraestructura hace posible completar casos prácticos de detección de fraudes al integrar API de terceros, extraer datos históricos y características de comportamiento del usuario, comparar actividades recientes y analizar la validez de las transacciones con un modelo en SageMaker.

Asimismo, Tecton abre nuevas posibilidades para la IA generativa, permitiendo integrar sus capacidades en aplicaciones actuales y ofrecer experiencias enriquecidas. Por ejemplo, los modelos de lenguaje a gran escala se pueden utilizar para asistencia al cliente, proporcionando respuestas informadas y contextuales.

En definitiva, con la colaboración de Tecton y SageMaker, los equipos de inteligencia artificial pueden desplegar aplicaciones de alto rendimiento en tiempo real, evitando la complejidad de la ingeniería de datos y logrando un camino más eficiente hacia la creación de valor utilizando la inteligencia artificial.