Los chatbots de inteligencia artificial y los asistentes virtuales se han vuelto cada vez más populares en los últimos años gracias a los avances en modelos de lenguaje de gran capacidad (LLMs por sus siglas en inglés). Entrenados con una gran cantidad de conjuntos de datos, estos modelos incorporan componentes de memoria en su diseño arquitectónico, lo que les permite entender y comprender el contexto textual.

Los usos más comunes para los asistentes chatbot se concentran en áreas clave, como mejorar las experiencias de los clientes, aumentar la productividad y la creatividad de los empleados u optimizar los procesos empresariales. Por ejemplo, se utilizan en el soporte al cliente, la resolución de problemas y la búsqueda de conocimiento tanto interna como externa.

A pesar de estas capacidades, uno de los desafíos clave con los chatbots es generar respuestas de alta calidad y precisión. Una manera de resolver este desafío es utilizar la Generación de Recuperación Aumentada (RAG). RAG es el proceso de optimizar la salida de un modelo LLM para que haga referencia a una base de conocimiento autorizada fuera de sus fuentes de datos de entrenamiento antes de generar una respuesta. La reordenación busca mejorar la relevancia de la búsqueda al reorganizar el conjunto de resultados devueltos por un recuperador con un modelo diferente.

RAG es una técnica que combina la recuperación de bases de conocimiento y los modelos generativos para la generación de texto. Funciona recuperando primero respuestas relevantes de una base de datos, usando esas respuestas como contexto para alimentar al modelo generativo y producir una salida final. Usar un enfoque RAG para construir un chatbot tiene muchas ventajas. Por ejemplo, recuperar respuestas de su base de datos antes de generar una respuesta puede proporcionar respuestas más relevantes y coherentes. Esto ayuda a mejorar el flujo de la conversación. RAG también escala mejor con más datos en comparación con los modelos puramente generativos y no requiere ajuste fino del modelo cuando se añade nueva información a la base de conocimiento.

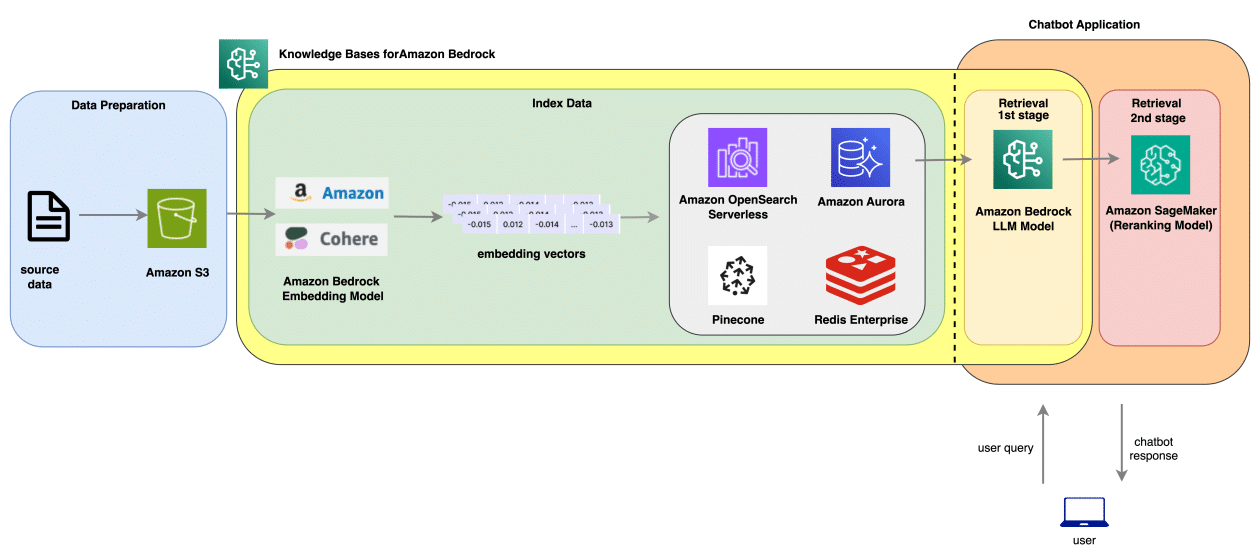

Para encontrar una respuesta, RAG usa una búsqueda vectorial a través de los documentos. La ventaja de usar la búsqueda vectorial es la velocidad y escalabilidad. En lugar de escanear cada documento para encontrar la respuesta, con el enfoque RAG, se convierten los textos (base de conocimiento) en embeddings y se almacenan estos embeddings en la base de datos. Los embeddings son una versión comprimida de los documentos, representada por un arreglo de valores numéricos. Después de que se almacenan los embeddings, la búsqueda vectorial consulta la base de datos vectorial para encontrar la similitud basada en los vectores asociados con los documentos.

La reordenación es una técnica que puede mejorar aún más las respuestas al seleccionar la mejor opción entre varias respuestas candidatas. Por ejemplo, para construir una solución de respuesta a preguntas, se puede utilizar «El Gran Gatsby», una novela de 1925 del escritor estadounidense F. Scott Fitzgerald, disponible públicamente a través de Project Gutenberg. Se pueden usar Bases de Conocimientos para Amazon Bedrock para implementar el flujo de trabajo RAG de extremo a extremo e ingerir los embeddings en una colección de búsqueda vectorial sin servidor de Amazon OpenSearch.

Una vez que se generan preguntas del documento utilizando un LLM de Amazon Bedrock y se crea una base de conocimientos que contiene el libro, se pueden recuperar respuestas usando la API de recuperación estándar RAG y una RAG de dos etapas, que implica una API de reordenación. Posteriormente, se pueden comparar los resultados de estos dos métodos.

Para evaluar la efectividad del RAG, se utiliza un marco llamado RAGAS, que proporciona un conjunto de métricas para evaluar diferentes dimensiones como la relevancia de la respuesta, la similitud de la respuesta y la relevancia del contexto, entre otros. Por ejemplo, en una prueba con «El Gran Gatsby», la evaluación de un enfoque RAG estándar puede arrojar métricas de relevancia y corrección, comparadas posteriormente con el enfoque de dos etapas donde se utiliza una reordenación adicional con modelos avanzados como bge-reranker-large disponible en Hugging Face Hub.

Las conclusiones mostraron que el uso de un modelo de reordenación mejora la relevancia del contexto, la corrección de la respuesta y la similitud a costa de un mayor tiempo de latencia. En resumen, la integración de modelos de reordenación con Bases de Conocimientos para Amazon Bedrock puede proporcionar un mejor rendimiento en términos de precisión y relevancia de las respuestas generadas.